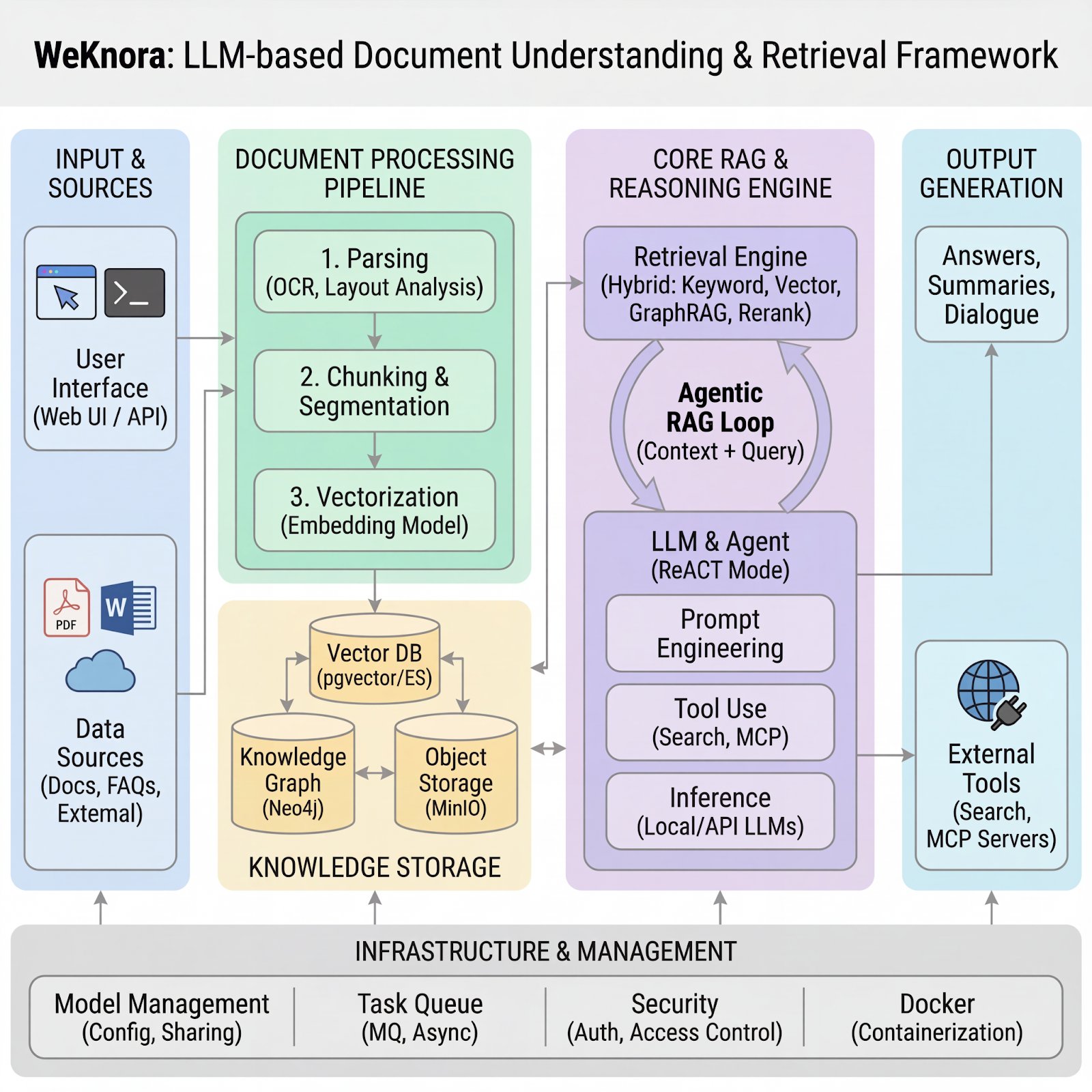

얼마전 Tencent에서 WeKnora v0.2.0을 런칭했습니다. 그런데 최근의 움직임과 약간 다른 느낌이 들었습니다.

최근 구글의 Gemini나 OpenAI의 모델들이 100만 토큰 이상의 방대한 컨텍스트를 한 번에 처리하기 시작하면서, 이제 RAG(Retrieval-Augmented Generation)의 시대는 끝났다라고 흔히들 얘기하는 시점이니까요. 책 수백 권 분량을 한 번에 AI에게 던질 수 있는데, 왜 굳이 복잡하게 RAG를 거쳐야 하느냐는 논리입니다.

한편으로는 이렇게 생각해볼 수 있습니다. 아무리 큰 바구니(컨텍스트)가 있어도, 그 안에 수많은 데이터를 다 담을 수는 없으며, 매번 수백만 줄의 텍스트를 읽게 하는 것은 비용과 시간을 낭비할 수 있다고 볼 수 있습니다. 이런 배경으로 인해 Tencent가 공개한 WeKnora는 Agentic RAG를 제시한 것이 아닌가 싶네요.

WeKnora를 이해하기 전에 왜 현 시점에서 RAG가 필수적인지 짚고 넘어갈 필요성이 있습니다.

- 비용 효율성: 100만 토큰을 매번 사용하면서 질문하는 것은 꽤 많은 통행료를 내는 것과 같습니다. RAG는 전체 데이터 중 필요한 것만 찾아 모델에게 전달하기에 비용을 절감할 수 있습니다.

- 답변 속도: 거대 모델이 방대한 데이터를 읽고 답하는 데는 꽤 오랜 시간이 걸릴 수 있습니다. 그러나 고성능 RAG 엔진은 빠르게 답변을 생성합니다.

- 환각 증상 방지: 모델이 아무리 똑똑해도 기억에 의존하면 거짓말을 할 수 있습니다. 명확한 근거를 주면 환각 증상을 예방할 수 있습니다.

위 관점에서 WeKnora를 보면, 단순히 문서를 데이터베이스에 저장하는 것을 넘어, AI가 그 문서를 이해하고, 필요한 정보를 찾기 위해 추론하며, 외부 도구를 사용해 검증하는 전 과정을 자동화합니다. 이미 Tencent 내부에서 Dog fooding으로 검증하지 않았을까? 라는 생각이 듭니다.

최근 업데이트된 v0.2.0은 단순한 검색 도구에서 자율형 AI 비서로 격상시켰습니다. 그 이유는 아래와 같습니다.

1) ReACT 에이전트 모드

기존 RAG는 질문을 받으면 검색하고 끝이었습니다. WeKnora의 에이전트 모드는 ReACT(Reason + Act) 알고리즘을 사용합니다.

- 추론(Reason): 사용자가 우리 회사 작년 매출과 올해 전망을 질문했네? 그럼 작년 결산내역과 올해 사업 계획서 두 개를 찾아야겠다.

- 행동(Act): 실제로 두 문서를 검색하고, 필요하다면 외부 검색을 통해 경쟁사의 동향까지 파악

- 결과: 단순 요약이 아니라, 여러 출처의 데이터를 종합한 인사이트를 제공

2) MCP(Model Context Protocol) 지원

WeKnora는 앤트로픽이 주도하는 MCP 규격을 채택했습니다. 이는 WeKnora가 구글 드라이브, 슬랙, 깃허브 등 다양한 외부 서비스 및 앱과 연결될 수 있음을 의미합니다. 지식이 문서내에서만 머물지 않고, 여러 서비스 및 도구를 통해 추출됩니다.

3) GraphRAG

단순 키워드 검색은 관련 단어가 없으면 답을 못합니다. WeKnora는 지식 그래프(Knowledge Graph) 기술을 도입해 단어와 단어 사이의 관계를 파악합니다. “A 프로젝트 담당자가 누구야?” 라는 질문에 “그 담당자가 작년에 쓴 B 문서에 따르면…” 식으로 연관도니 모든 정보를 캐낼 수 있습니다.

WeKnora의 새로운 기능은 아래와 같습니다.

WeKnora는 모듈 방식을 채택하여, 문서에 대한 이해와 검색 파이프라인 구축을 지원합니다.

ReACT 에이전트 모드

- 내장 도구를 사용하여 지식 기반을 검색할 수 있는 새로운 에이전트 모드

- MCP 도구 및 웹 검색을 호출하여 외부 서비스에 엑세스

- 종합적인 요약 보고서를 위한 여러번의 반복 및 숙고

- 교차 지식 기반 검색 지원

다중 유형 지식 기반

- FAQ 및 문서 지식 기반 유형 지원

- 폴더 가져오기, URL 가져오기, 태그 관리

- 온라인 지식 입력 가능

- FAQ 항목 일괄 가져오기 및 삭제

MCP 도구 통합

- MCP 프로토콜을 통해 에이전트 기능을 확장

- 내장형 uvx 및 npx MCP 런처

- Stdio, HTTP Streamable, SSE 전송 지원

웹 검색 통합

- 확장 가능한 웹 검색 엔진

- DuckDuckGo 내장 검색 기능

대화 전략 설정

- 에이전트 모델과 일반 모드 모델을 별도로 구성

- 구성 가능한 검색 임계값

- 온라인 프롬프트 구성

- 다중 턴 대화 동작에 대한 정밀한 제어

새롭게 디자인된 UI

- 대화 인터페이스에서 상담원 모드/일반 모드 전환 기능

- 툴 호출 실행 프로세스 표시

- 시간 순서대로 그룹화된 세션 목록

- 지식 기반 페이지의 탐색 경로

인프라 업그레이드

- MQ 기반 비동기 작업 관리

- 버전 업그레이드 시 데이터베이스 자동 마이그레이션

- 빠른 개발 모드 지원

AI 모델 자체가 똑똑해지는 것보다 더 중요한 것은 “모델이 데이터를 얼마나 정확하게 알고 있는가?” 입니다. WeKnora는 Long Context LLM이 줄 수 없는 경제성, 정확성 그리고 확장성을 제공합니다.

에이전틱 RAG가 궁금하면 한번 경험해보세요.

WeKnora 기술 스택

- Backend: Go

- Frontend: Vue.js (중국이다보니…)

- 백터 데이터베이스: PostgreSQL(pgvector), Elasticsearch

- LLM 지원: Qwen, DeepSeek, Ollama 등

- 지식 그래프: Neo4j (선택 사항)

설치 참고: https://github.com/Tencent/WeKnora

0 Comments:

댓글 쓰기