대부분 기업이 온프레미스 환경에서 DR 없이 서비스를 운영해 왔던 이유는 명확합니다. "비용 효율성" 때문입니다. 인프라를 소유하고 최적화하여 사용하면, 겉보기에는 클라우드보다 저렴해 보입니다. 그러나 이는 "재해"라는 변수를 배제한 계산법입니다. 비즈니스가 성장하고 서비스 연속성이 필수 조건이 되는 순간, 온프레미스의 비용 구조는 거대한 장벽에 부딪힙니다.

왜 그럴까요?

온프레미스에서 DR을 구축하면 단순히 서버 대수만 두 배가 되는 것이 아닙니다. 그 이유는 아래와 같습니다.

상시 유휴 자산의 발생: DR 센터는 평상시에 거의 사용되지 않습니다. 그러나 주 센터와 동일한 사양의 서버, 스토리지, 네트워크 장비를 구매(CAPEX)해야 합니다. 99%의 시간 동안 놀고 있는 장비에 투자하는 꼴입니다.

운영 복잡도의 기하급수적 증가: 데이터 센터를 하나 더 관리한다는 것은 전기료, 냉각비, 상주 인력, 보안 관제 비용이 고스란히 추가됨을 의미합니다.

동기화의 늪: 두 센터 간 데이터 정합성을 맞추기 위한 고가의 전용 회선과 솔루션 비용은 "비용 효율성"이라는 단어를 무색하게 만듭니다.

클라우드쪽으로 생각해볼까요?

클라우드로 단순히 서버를 옮기는(Lift & Shift) 것이 아니라, "클라우드 네이티브" 아키텍처를 택했을 때 DR 비용은 혁신적으로 줄어듭니다. 그 이유는 아래와 같습니다.

첫째, "소유"에서 "대기"로: Pilot Light 전략

클라우드 네이티브 환경에서는 DR을 위해 모든 서버를 준비할 필요가 없습니다. 핵심 데이터만 실시간 복제하고, 서비스 자원은 "코드(IaC)" 형태로 있다가 재해 발생 시에만 수 분 내로 인프라를 프로비저닝하여 기동합니다.

둘째, 스케일링을 통한 유연성

온프레미스 DR은 최대 트래픽을 견딜 만큼의 장비를 미리 사야 합니다. 반면 클라우드 네이티브는 장애 시 최소 사양으로 복구를 시작한 뒤, 트래픽이 몰리면 서버를 늘릴 수 있습니다. "놀고 있는 장비"에 대한 비용 지불이 사라집니다.

셋째, 서버리스와 매니지드 서비스 활용

DB 복제나 메시지 큐 등을 CSP의 매니지드 서비스를 활용하면, 인프라 관리 부담을 CSP에게 넘기는 것입니다. 즉. 선택과 집중을 할 수 있습니다. 이는 인적 운영 비용을 낮출 수 있습니다.

DR이 없었을 때는 온프레미스의 비용이 저렴할 수 있지만, DR을 하는 순간 비용은 증가합니다. 운영 효율까지 본다면 더 많겠지요. 재해 복구를 고려해서 인프라를 선택할 때는 생각을 바꿔야 합니다.

"온프레미스가 클라우드보다 저렴한가?" 에서 "재해 복구가 가능한 수준의 인프라를 구축할 때, 어디가 더 경제적인가?"로 질문을 해야 합니다.

위 질문에 대한 답은 무엇일까요?

클라우드 네이티브는 단순한 기술적인 유행이 아니라, "가용성"과 "경제성"이라는 두 마리 토끼를 잡기 위한 현실적인 전략입니다.

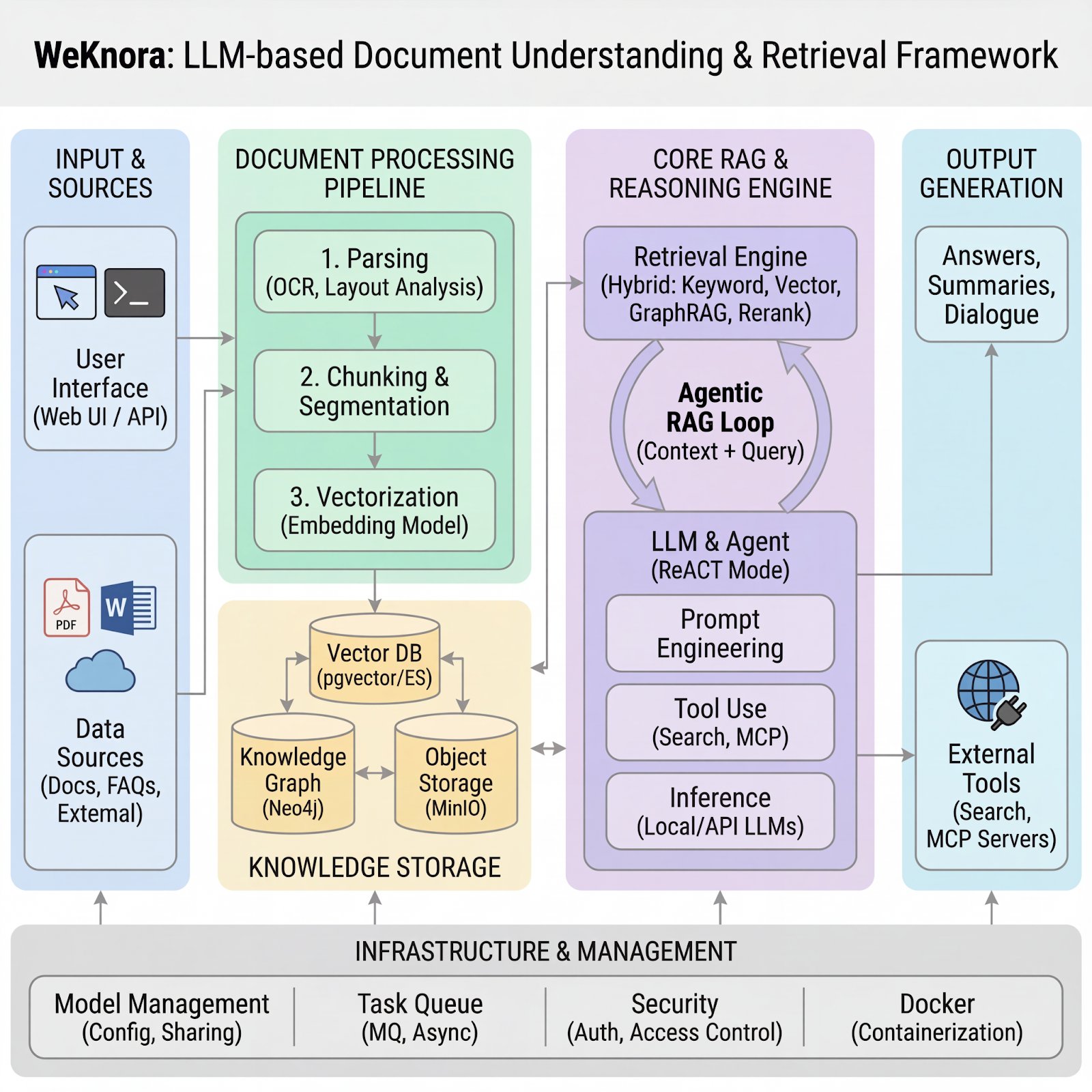

참고로 비용 시뮬레이션을 해보았습니다.

#비용 시뮬레이션 설정

- 서비스 규모: 50대의 물리/가상 서버, 100TB 데이터 저장소

- 기간: 3년 TCO 기준

- DR 목표: RTO 4시간 이내, RPO 1시간 이내

#온프레미스 DR

온프레미스에서 DR을 구축하면 아래의 항목에서 비용이 발생합니다. (3년 합계)

위 시나리오 (A)와 (B)를 비교하면 약 1.9배의 비용 상승이 발생합니다. 단순히 장비만 두 배가 되는 것이 아니라, 두 데이터 센터를 잇는 전용 회선과 이중화된 운영 인력 비용이 추가되기 때문입니다. (보안 비용은 포함하지 않았습니다.) 즉, 온프레미스에서 DR을 하면 비용은 거의 2배가 됩니다.

클라우드 네이티브 시나리오 (C)는 DR이 포함되어 있음에도 DR이 없는 온프레미스 단일 센터와 비용 차이가 크지 않습니다. 이유는 클라우드는 평상 시 DR용 서버를 켜두지 않는 Pilot Light 방식을 사용하기에, 실제 장애가 나기 전까지는 하드웨어 비용을 지불하지 않기 때문입니다. (DB 비용만 존재) Pilot Light는 데이터베이스는 실시간 복제하되, 애플리케이션 서버는 꺼두었다가 재해 시에만 즉시 생성하는 전략입니다.

이제까지 시장은 온프레미스가 더 비용 효율적이라는 의견이 지배적이었습니다. 그건 DR을 고려하지 않은 단일 센터 기준으로는 맞는 이야기입니다. 그러나 DR을 필수조건으로 넣는 순간 판도는 바뀝니다.

CPEX의 소멸: 5억 원의 장비를 미리 사서 썩힐 필요가 없습니다. 그 자본을 다른 사업에 투자할 수 있는 기회 비용이 발생합니다.

규모의 경제와 유연성: 클라우드는 재해 시에만 서버를 빌려 씁니다. 온프레미스처럼 혹시 모를 상황에 대비해 미리 사두는 유휴 자원이 없습니다.

관리의 자동화: 온프레미스 DR은 두 장소의 OS 패치, 하드웨어 노후화를 각각 챙겨야 합니다. 클라우드 네이티브는 걱정이 없습니다.

또한, 요즘은 환율 그리고 반도체 가격이 상승하고 있는 시장상황에 처해 있습니다. 국내 기업이 사용하는 서버 장비 대부분은 외산이며 달러 결제가 기본입니다.

환율 리스크: 고환율 기조가 유지되는 상황에서 하드웨어 수입 비용은 기업의 예상치를 상회합니다. 온프레미스 DR은 모든 장비를 직접 구매해야 하므로 환율 변동에 무방비로 노출됩니다.

클라우드의 방어 기재: 클라우드 서비스 역시 달러 기반이지만, 예약 인스턴스 혹은 Savings Plans를 통해 할인도 받을 수 있고, CSP가 긴 기간으로 공급사와 계약을 하기에 반도체 상승에 따른 환경 변화가 크지 않습니다.

끝으로,

온프레미스 DR이 “장비를 하나 더 사는 것”이라면, 클라우드 네이티브는 “필요할 때만 인프라를 생성하는 것”입니다. 효율성을 고려한다면 아래를 참고해야 합니다.

Pilot Light 아키텍처: 데이터베이스만 최소한으로 복제하고, 웹/앱 서버는 재해 시에만 코드를 실행하여 생성. 이 경우 DR 비용은 온프레미스보다 적은 수준으로 절감 가능

CAPEX에서 OPEX로: 불확실한 경기 상황에서 DR을 위한 투자를 묶어두는 것은 리스크가 클 수 있음. 클라우드는 초기 투자비 없이 매달 사용량만큼 지출하기에 재무 유동성 확보에 유리 (단, 클라우드 네이티브가 되어 있어야 함)

운영 자동화: CSP의 매니지드 서비스(RDS, EKS 등)를 활용하면 하드웨어 관리 및 패치 비용을 절감할 수 있어, 운영 리소스를 낮출 수 있음

“온프레미스 단일 센터가 가장 저렴하다.”는 생각은 재해라는 리스크를 배제했을 때만, 유효합니다. 그러나 DR이 필수인 시대에 반도체 가격 상승과 고환율이라는 거센 파도를 온몸으로 맞으며 온프레미스 DR을 구축하는 것은 비합리적입니다.

클라우드 네이티브로의 전환은 단순히 기술을 바꾸는 것이 아닙니다. 인프라를 “고정 자산”에서 “유연한 비용”으로 전환하는 거시경제 리스크를 방어하는 최선의 재무 전략이라고 생각합니다.